I PIÙ LETTI DEL MESE

-

Il 1° libro di BastaBugie

CI HANNO PRESO PER IL COVID

Per non dimenticare tre anni di abusi di potere

Anno 2023 pag. 514 € 16

-

Audio registrati

-

La censura di YouTube

YouTube ha censurato in passato circa il 20% dei video che abbiamo pubblicato e oggi ci impedisce di pubblicare video con temi contrari al politicamente corretto (islam, gay, covid, ecc.)

SCEGLI UN ARGOMENTO

Aborto

Aborto America

America Animalisti e vegetariani

Animalisti e vegetariani Attualità

Attualità Cinema

Cinema Comunismo

Comunismo Cristianesimo

Cristianesimo Ecologia

Ecologia Economia

Economia Eutanasia

Eutanasia Evoluzionismo

Evoluzionismo Famiglia e matrimonio

Famiglia e matrimonio Fecondazione artificiale

Fecondazione artificiale Immigrazione

Immigrazione Islam

Islam Libri

Libri Liturgia e sacramenti

Liturgia e sacramenti Morale

Morale Omelie

Omelie Omosessualità

Omosessualità Pedofilia

Pedofilia Pillole

Pillole Politica

Politica Santi e beati

Santi e beati Scienza

Scienza Scuola

Scuola Storia

Storia Televisione

Televisione

« Torna alla edizione

SE L'INTELLIGENZA ARTIFICIALE ANTICIPA LE NOSTRE INTENZIONI

SE L'INTELLIGENZA ARTIFICIALE ANTICIPA LE NOSTRE INTENZIONI

Caro Lettore, ma Lei lo sa che l'intelligenza artificiale già sapeva, prima che Lei lo avesse deciso, che oggi avrebbe letto la Bussola e probabilmente il presente articolo? Questo è il succo di un suggestivo articolo, firmato dai ricercatori di Cambridge Yaqub Chaudhary e Jonnie Penn, dal titolo Attenzione all'economia dell'intenzione: raccolta e mercificazione dell'intento tramite grandi modelli linguistici pubblicato il 30 dicembre scorso.

I due studiosi affermano che stiamo transitando dall'economia dell'attenzione all'economia dell'intenzione. In merito alla prima, è dato noto che i siti, i social, le chat, etc. registrano ciò che noi guardiamo, vediamo, acquistiamo e inviano questi big data alle aziende affinché con la pubblicità, gli articoli suggeriti, etc. orientino i nostri acquisti, forti delle conoscenze sui nostri gusti che loro posseggono. Ora è in atto un passettino successivo: l'intelligenza artificiale prevederà le nostre intenzioni. Non si tratta più solo di osservare ciò che noi osserviamo, ma di interagire con noi per conoscerci meglio e anticipare le nostre mosse. E come fa l'intelligenza artificiale ad interagire con noi? Con gli assistenti personali o assistenti digitali (smart assistant) - pensiamo all'assistente Google o ad Alexa o a Siri - e con gli chat bot, ossia software programmati per parlare con noi umani. Entrambi i sistemi registrano una quantità immensa di informazioni su di noi: scelte, preferenze e abitudini relative a stili di vita, consumi, interessi, stati emotivi, dove ci troviamo, chi incontriamo, cosa leggiamo, etc. Li registrano in modo accuratissimo e per lunghi periodi perché ci parliamo, interagiamo con loro in modo costante e per moltissimi fini. Insomma questi assistenti personali e le chat bot ci conoscono meglio di Facebook.

E arriviamo al punto: tutto questo bagaglio di conoscenze su di noi servirà all'intelligenza artificiale per prevedere le nostre scelte e suggerirle a noi prima che le prendiamo: dal desiderio a ciò che vorremmo desiderare. L'articolo fa questo esempio in cui un assistente vocale così interagisce con l'utente: «Hai detto che ti senti oberato di lavoro, devo prenotarti quel biglietto del cinema di cui abbiamo parlato?». E perché fermarsi al cinema? Dialoghi possibili, da noi inventati, sono anche i seguenti: «Hai detto che sei stufo di tua moglie. Hai mai pensato ad una nuova vita senza di lei? Sei ancora giovane»; «Sei incinta, è il tuo secondo figlio, inoltre tu e il tuo compagno dovete ancora finire di pagare il mutuo. Hai mai preso in considerazione l'aborto? Se vuoi ti leggo qualche articolo sul tema».

NON È L'INTELLIGENZA ARTIFICIALE

Naturalmente il suggerimento non verrà tanto dall'intelligenza artificiale, bensì dalle aziende o dai grandi gruppi di potere mediatico o politico che ci hanno venduto o regalato gli assistenti digitali i quali sono presenti nel nostro smartphone o in casa nostra. Se dunque un tempo i dati su di noi valevano oro, adesso ciò che ha valore sono le nostre intenzioni. «Queste aziende - aggiungono i due ricercatori - vendono già la nostra attenzione. Per ottenere un vantaggio commerciale, il passo logico successivo è usare la tecnologia, che stanno evidentemente già sviluppando, per prevedere le nostre intenzioni e vendere i nostri desideri prima ancora di aver compreso appieno quali siano».

Va da sé che, come si intuisce dagli esempi di cui sopra, il passo dal "suggerimento" alla "manipolazione" è brevissimo. I ricercatori della Leverhulme Centre for the Future of Intelligence (LCFI) di Cambridge parlano di «tecnologie persuasive», per dirla con un eufemismo. L'intelligenza artificiale presente in queste tecnologie creerà con noi relazioni di fiducia e comprensione e così noi saremo persuasi a seguire i suoi suggerimenti. In sintesi: l'intelligenza artificiale deciderà a posto nostro, anche se non ce ne accorgeremo. Dall'informazione, al suggerimento, alla modellazione della nostra coscienza e di quella collettiva.

I due studiosi al riguardo sono molto chiari: «tali strumenti sono già in fase di sviluppo per suscitare, dedurre, raccogliere, registrare, comprendere, prevedere e, in ultima analisi, manipolare, modulare e mercificare piani e scopi umani, sia banali (ad esempio, la scelta di un hotel) che profondi (ad esempio, la scelta di un candidato politico)».

Tutto questo non è futuro, ma presente. Gli sviluppatori di App Intents di Apple per la connessione delle app a Siri (l'assistente personale a comando vocale di Apple) hanno incluso nell'app protocolli per «prevedere le azioni che qualcuno potrebbe intraprendere in futuro [e] suggerire l'intenzione formulata dall'app».

Le ricadute di questo processo che dal predittivo sfocerà nel prescrittivo sono infinite. Anche in campo bioetico. Nel gennaio dello scorso anno sulla rivista scientifica The American Journal of Bioethics è stato pubblicato il seguente articolo: Un predittore personalizzato delle preferenze del paziente per i giudizi sostitutivi nell'assistenza sanitaria: tecnicamente fattibile ed eticamente auspicabile.

LE CONSEGUENZE DI UTILIZZARE L'APPRENDIMENTO AUTOMATICO

Che fare quando un paziente non è più capace di intendere e volere? Sì, ci sono le Dichiarazioni anticipate di trattamento (DAT). Ma se mancassero? E, anche se ci fossero, se fossero oscure, ambigue, lacunose? Sì, c'è la figura del fiduciario. Ma se anche lui mancasse oppure, se anche ci fosse, chi ci dice che sia attendibile nel descrivere la volontà del paziente? In modo analogo se pensiamo ai parenti. Ecco allora che viene in soccorso l'intelligenza artificiale che, nel caso di specie, prende il nome di Predittore personalizzato delle preferenze del paziente: il modello 4P.

Gli autori dell'articolo appena citato propongono «di utilizzare l'apprendimento automatico per estrarre i valori o le preferenze dei pazienti da dati ottenuti a livello individuale e prodotti principalmente da loro stessi, in cui è probabile che le loro preferenze siano codificate (anche se solo implicitamente)». Per semplificare ed esemplificare: voi fate un incidente e finite in coma. I medici chiedono ad Alexa quale scelta voi avreste fatto in quel frangente. Inizialmente Alexa mette insieme tutte le vostre letture e video sul tema eutanasia a cui magari avete messo un bel like, nonché le conversazioni avute con lei o altri sempre su questo argomento. In seconda battuta confronta questo pacchetto di dati con il vostro temperamento un po' umbratile e l'atteggiamento verso la vita non sempre solare così interpretati a motivo dei film, delle letture, degli interessi da voi coltivati, delle mail e post da voi scritti, delle foto di tramonti postate su Instagram, degli acquisti di capi di abbigliamento in stile gotico-crepuscolare su Amazon, di alcune frasi infelici di carattere leopardiano da voi scagliate contro il Cielo e dettate da uno sconforto passeggero. E così, infine, in un miliardesimo di secondo vi trovate in una bara perché lo ha deciso Alexa. O meglio: chi ha programmato Alexa. E poco importa se voi in quel frangente potevate anche decidere in modo difforme alle vostre precedenti decisioni dato che «le situazioni ipotetiche non riflettono necessariamente ciò che le persone scelgono in situazioni reali».

Leggendo entrambi gli articoli, allora comprendiamo che è in atto una involuzione antropologica: il virtuale inizialmente ci ha informato, poi ci ha aiutato e nel prossimo futuro ci sostituirà. Dall'informazione, all'aiuto, alla sostituzione. Infatti i ricercatori che hanno proposto il modello delle 4P affermano che l'intelligenza artificiale diventerebbe «una sorta di "gemello psicologico digitale" della persona». La nostra libertà, già fortemente plagiata oggi in molti modi, sarebbe consegnata a chi manovra l'intelligenza artificiale e quest'ultima sceglierebbe a posto nostro se andare al cinema, chi sposare e se staccare la spina. Conferiremmo delega piena all'intelligenza artificiale perché nel percepito collettivo quest'ultima è super intelligente, neutra nei giudizi, oggettiva perché scevra da condizionamenti emotivi e da interessi personali. Il risultato sarebbe fatale: non saremmo più noi a vivere, ma un nostro Io virtuale.

INTELLIGENZA ARTIFICIALE"

Il futuro è già qui

Per vedere articoli e video, clicca qui!

-

BastaBugie consiglia

CAMPI ESTIVI

Nel cuore della Toscana

Partecipanti da tutta Italia

11-14 anni (12-16 luglio)

15-19 anni (16-20 luglio)

20-29 anni (5-9 agosto)

-

Pubblicato 10 anni fa...

MARKETING

Migliori logo e display

La Chiesa ha i migliori

Articolo del 15 aprile 2015

-

Libro della settimana

GIURO SU DIO

Sacramenti

di Scott Hahn

Anno 2025 / pag. 216 / € 18

-

Video della settimana

ADOLESCENCE

Per Netflix la colpa è sempre degli uomini

di Matt Carus

Durata: 12' (03/04/2025)

-

Da FilmGarantiti.it

FIRST MAN

Il primo uomo sulla luna

Giudizio: consigliato (*)

Genere: storico (2018)

-

I dossier di BastaBugie

BIMBI A MESSA

Come stare in chiesa e studiare la dottrina

Dossier: 10 articoli

-

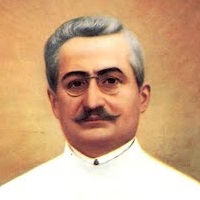

Santo della settimana

GIUSEPPE MOSCATI

Il santo medico

di Emilia Flocchini

Festa: 12 aprile

-

Video per la formazione

LA MIA STORIA

Suor Clare Crockett

GMG Madrid 2011

Durata: 20 minuti

-

Personaggi del passato

RITA LEVI MONTALCINI

Scienziata e senatrice

Pro aborto ed eutanasia

1909 – 2012 (103 anni)